Emotionen messen mithilfe Künstlicher Intelligenz

Der Anspruch an die Benutzungsfreundlichkeit von Websites und Apps steigt, die Bedienung soll im besten Fall positive Emotionen hervorrufen. Das OHM User Experience Center der Technischen Hochschule Nürnberg Georg Simon Ohm (Ohm) forscht daran, wie sich diese Emotionen messen lassen und wie durch Künstliche Intelligenz eine verbesserte User Experience entsteht.

Computersysteme und Software müssen heutzutage mehr bieten als reine Interaktionsmöglichkeiten. Die Nutzer*innen brauchen eine verständliche inhaltliche Führung und wünschen sich dabei eine positive Erfahrung. Dabei spielen die grafische Gestaltung oder die Unterstützung bei Problemen eine entscheidende Rolle. Hier spricht man von der User Experience (UX), bei der die Nutzer*innen nicht nur eine Aufgabe erledigen, sondern diese in ein erfreuliches Gesamterlebnis eingebettet ist. Doch wann genau wird eine Website oder App als angenehm oder unangenehm empfunden und wie kann das gemessen werden?

Damit beschäftigt sich Prof. Dr. Patrick Harms, Leiter des OHM User Experience Center (OHM-UX) der Ohm. In seinem Projekt „EMO-KI: Interaktions- und KI-basierte Emotionserkennung zur Bewertung der User Experience“, untersucht er die Messbarkeit von Emotionen der Nutzer*innen und möchte so die UX verbessern. Das ist vor allem bei kritischen Schnittstellen, wie zur Reservierung eines Impftermins oder für Verwaltungsprozesse, relevant. „Die Messung der Usability, der Nutzungsfreundlichkeit von Websites und Apps, ist anhand harter Fakten möglich, beispielsweise durch Zeiterfassung oder das Zählen von Klicks“, sagt Harms. „Bei User Experience ist das schwieriger, da sie in vielen Aspekten auf subjektiven Wahrnehmungen beruht und Nutzerreaktionen, wie Stimmungsänderungen oder kurzfristige Emotionen, hervorruft.“

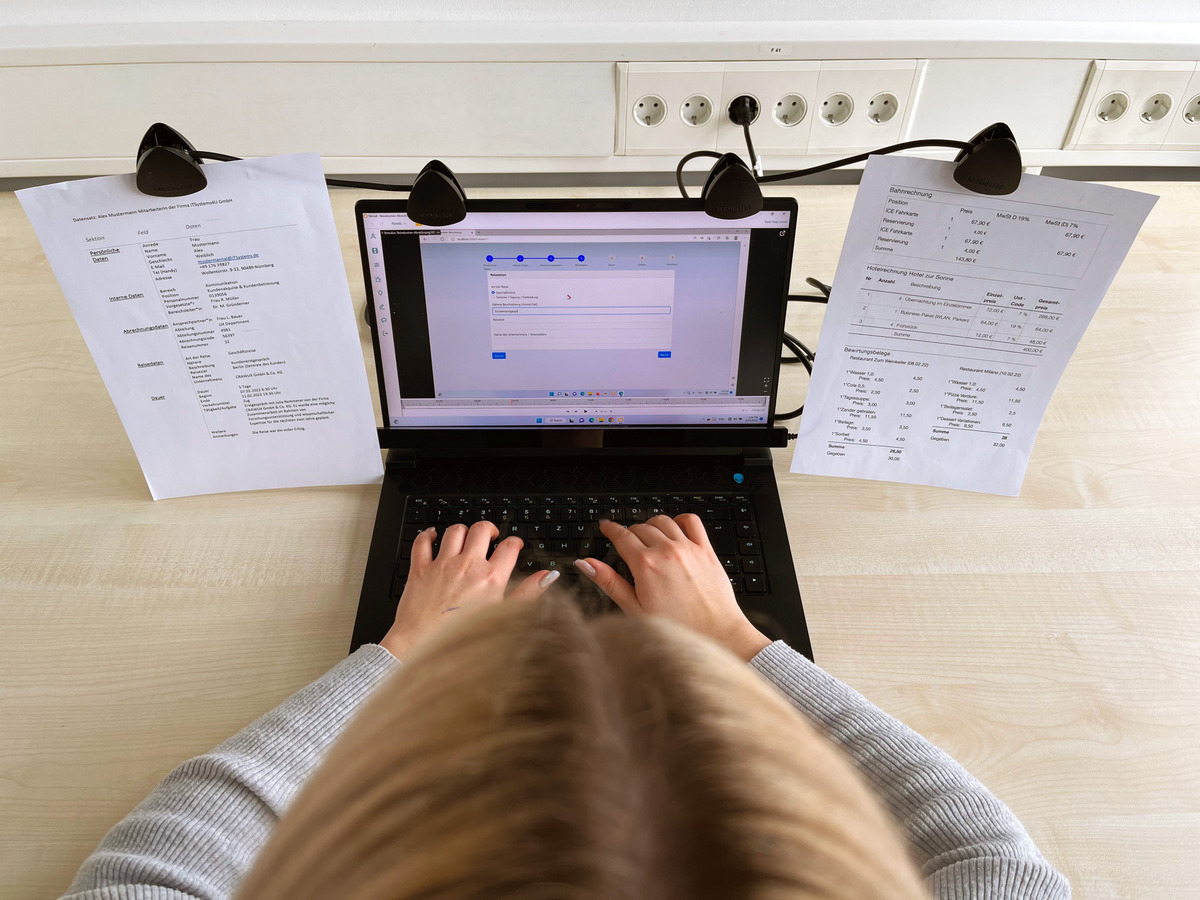

Bereits heute erheben die Websites und Apps Daten zur Bedienung von Tastatur, Maus oder Touchoberflächen sowie über die Bearbeitungszeit. Im Projekt EMO-KI ermitteln Harms und sein Team, ob diese Daten auch Aufschluss auf die Emotionen und Stimmungen erlauben. In einer Studie bedienen Proband*innen eine Nutzerschnittstelle. Währenddessen werden ihre Stimmungen und Emotionen über Befragungen, Eyetracking und beispielsweise Herzfrequenzmessung erfasst. Gleichzeitig werden ihre Interaktionen auf technischer Ebene sehr detailliert aufgezeichnet, um einen Datensatz für eine weiterführende automatisierte Auswertung zu erhalten. „Diesen Datensatz können wir mit den Emotions- und Stimmungsdaten in Verbindung bringen und unter anderem emotional auffällige Momente der Interaktion in den Daten separieren“, erklärt Harms. „Daraus leiten wir dann Hypothesen über den Zusammenhang der Datensätze ab. Die Strukturen der separierten Interaktionsdaten können wir mit Hilfe von Künstlicher Intelligenz erkennen.“

Durch das Forschungsprojekt kann das Team ermitteln, ob Nutzerschnittstellen für eine Person hilfreich sind oder welcher Teil zu einem negativen Stimmungswechsel führt und verbessert werden muss. Ebenso kann der Bearbeitungsprozess einer Website oder App so effizient wie möglich gestaltet werden, was die Usability erheblich steigert und so die Nutzer*innen zufrieden stellt. Das Projekt wird von der STAEDTLER Stiftung gefördert.

Im OHM-UX entstehen Technologieentwicklungen im Bereich der Mensch-Maschine-Interaktion. Seit Beginn des Wintersemesters 2022/23 sind sieben Professoren aus drei Fakultäten der Ohm im Kompetenzzentrum interdisziplinär tätig. Sie haben forschungsorientierte Professuren im Rahmen der Hightech Agenda Bayern, wodurch das OHM-UX seinen Fokus auf die Forschung in unterschiedlichen Bereichen der Mensch-Maschine-Interaktion legen kann. Die Professoren bündeln ihre jeweiligen Kompetenzen und erschließen so neue Forschungsfelder – von Augmented Reality über Game Design bis zu KI-Systemen für autonome Fahrzeuge oder Medizintechnik.

Foto: OHM-UX